Python と Lalicat: 効率的かつ安全な Web スクレイピングのための究極のツール

Tue May 30 2023admin

Webスクレイピングとは何ですか?どのように機能するのでしょうか?

Web スクレイピングは、Reddit などの Web サイトからデータを収集するために採用される、高度に熟練した自動化された方法論です。この技術は、一般に Web クローラーまたはスパイダーと呼ばれるコンピューター プログラムに依存しており、Web ページからテキスト コンテンツ、ビジュアル、ハイパーリンク、その他の貴重なデータを抽出します。多様な Web サイトとデータ要求には、独自の Web スクレイピング手法が必要です。 API を介して構造化データを提供する特定の Web サイトからデータを取得するのは比較的簡単ですが、他の Web サイトではデータ集約のために HTML コードを解析する複雑なプロセスが必要となり、より困難になります。

注目に値するのは、Python、R、Selenium などのコンピューター言語とツールが、Web スクレイピングに広く利用されているリソースの 1 つにランクされているということです。これらの技術を利用することで、Web スクレイパーは Web サイトの閲覧、フォームへの記入、データの抽出という行為を自動化します。この自動化されたアプローチは、時間と労力を節約するだけでなく、データ蓄積の精度と信頼性を高めます。その結果、Web スクレイピング テクノロジーは、現代のデータ分析と研究活動において不可欠かつ重要な役割を果たしています。

Webスクレイピングのメリット

Web スクレイピング テクノロジーは、企業、個人、学術界が広大なインターネットから迅速かつ上手にデータを収集できるようにする、最も重要な手段として不可欠な役割を担っています。オンライン情報量が絶え間なく増大する時代において、Web スクレイピングは、データの体系的な取得と細心の注意を払った評価のための極めて重要なアプローチとして浮上しました。

Web スクレイピングは、市場調査、リード生成、コンテンツ集約、データ分析を含むがこれらに限定されない、いくつかの個別の対象を絞ったアプリケーションとして現れます。市場調査では、Web スクレイピングを利用して貴重な市場データを収集し、価格設定の洞察、製品評価、顧客感情分析などの競合情報を収集します。逆に、リード生成では、Python を介した Web スクレイピングの可能性を利用して、電子メール アドレスや電話番号などの連絡先の詳細を Web サイトから取得します。コンテンツの集約という点では、Web スクレイピングは、ニュース記事やソーシャル メディアの投稿からブログのエントリに至るまで、多種多様なコンテンツ ソースを照合するための優れたツールとして機能し、それによって特定の主題を中心とした包括的なリポジトリを構築します。さらに、Web スクレイピングをデータ分析に適用すると、研究者やアナリストは、消費者行動の調査、傾向の監視、センチメント分析の実施など、さまざまな目的でデータを蓄積および精査できるようになります。

Web スクレイピングはその中核として、意思決定プロセスを促進し、データに関する明確な洞察を提供し、研究活動の期間を短縮する影響力のある手段として機能します。それにもかかわらず、Web スクレイピング技術を使用する場合は、倫理的かつ責任ある慣行を実践することが不可欠です。クロールされている Web サイトによって規定されている利用規約を遵守し、個人のプライバシー権を保護しながら、データの合法的かつ倫理的な利用を確保することが最も重要です。

ラリカットとは何ですか?ユーザーをどのように支援しますか?

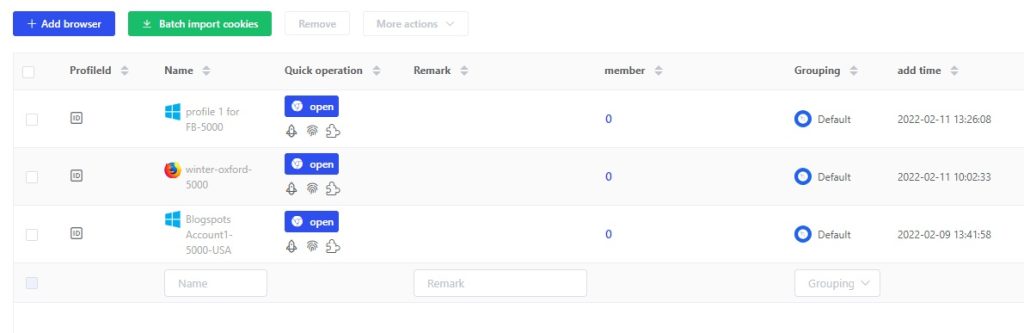

Lalicat は、多様なオンライン ID を適切に管理するために調整された、安全性の高いブラウジング プラットフォームとして機能します。 Web 開発者向けに特別に設計された Lalicat は、Facebook、Google、Cloudflare などの洗練されたプラットフォームによる検出から Web クローラーを保護するシールドとして機能します。 Lalicat は、密閉された機密デジタル環境をユーザーに提供し、複数のブラウザ アカウントの作成と管理、Web スクレイピング操作の自動化を含む、シームレスな Web ブラウジング エクスペリエンスを可能にします。 Lalicat の領域内では、ユーザーは複数の設定ファイルを簡単に確立して維持できます。各設定ファイルには、個別で交差しない独自のパラメータ配列が与えられています。この独自の機能により、ユーザーは疑惑を抱かれることなく、単一の Web サイト上の複数のアカウントに簡単にアクセスできるようになります。注目すべきことに、Meta や Amazon のような追跡能力の巨大企業でさえ、Lalicat エコシステム内で活動しているユーザーを通常の Chrome ユーザーとして認識されているため、区別できないことに気づいています。このパラダイムシフトは、多数のソーシャルメディア、広告、または電子商取引アカウントの管理を必要とする企業や個人にとって変革をもたらすことが証明されています。

さらに、Lalicat はアイデンティティ管理能力に加えて、高度なスクレイピング機能を備えており、ユーザーは禁止されるリスクを冒さずに、事前構築またはカスタムのスクレイパーを使用して Web サイトからデータを取得できるようになります。この属性は、市場調査、競合分析、その他の学術研究のためにデータを収集しようとしている企業や研究者にとって、非常に重要かつ貴重な資産として浮上します。 Lalicat のスクレイピング機能は、検出、禁止、その他の形式の制限の迫りくる不安を感じることなく、ターゲットの Web サイトからデータを収集する手間のかからない手段をユーザーに提供します。これにより、データ収集の効率と精度が最適化され、市場分析と調査活動の品質と有効性が強化されます。

本質的に、Lalicat は、Web スクレイピングの技術を向上させながら、多様なオンライン ID の管理を合理化する、非常に実用的でユーザーフレンドリーなツールとして登場します。 Lalicat は、シームレスなマルチアカウント管理を可能にし、検出や制限から保護された堅牢なスクレイピング メカニズムをユーザーに提供することで、生産性の向上を促進し、データの整合性を強化します。さらに、プライベート ブラウジング、自動 Web スクレイピング、複数のブラウザ アカウントの作成と管理を含む包括的な機能スイートにより、Lalicat は包括的で安全なブラウジング ソリューションとして位置付けられます。 Web データの取得に依存している企業や研究者向けに、Lalicat はデータ収集と分析作業の効率と精度を高めることができる、効率的で信頼性が高く安全なツールを提供します。

Web スクレイピング用に Lalicat をセットアップして使用する手順

ステップ 1: アカウントの作成を開始します。 Lalicat の旅を始めるには、アカウントを作成する必要があります。この最初のステップでは、Lalicat の公式 Web サイトにアクセスして作成プロセスに参加し、登録用の電子メール アドレスを入力する必要があります。アカウントが正常に作成されたら、プラットフォームへのログインに進み、ブラウザ プロファイルの構成を開始できます。

ステップ 2: ブラウザ プロファイルを偽造します。 Lalicat は、本物のユーザーの行動をエミュレートする独特のペルソナとしてブラウザー プロファイルを採用します。プロファイルを作成する前に、Google Chrome や Mozilla Firefox などの目的のブラウザを選択する必要があります。その後、ユーザー エージェント、サムプリント、IP アドレスなどの重要な要素を組み込んで、構成ファイルを注意深く形成できます。これらの特徴は総合的にプロファイルの信頼性を高めることに貢献し、検出の可能性を効果的に低減します。

ステップ 3: プロキシ設定を微調整します。ステルスのベールをさらに強化するために、ブラウザ プロファイル内のプロキシ設定を調整する機能を備えています。この戦略的な戦略により、Web サイトへの訪問ごとに個別の IP アドレスが与えられるため、オンラインでの行為の熱心な監視が妨げられます。

ステップ 4: Reddit Web スクレイピングの取り組みに着手します。プロキシ設定の確立とブラウザ プロファイルの綿密な構築により、Web スクレイピングの領域に乗り出す準備が整いました。これには、通常 Python などのコンピューター言語を利用した Web スクレイピング スクリプトの作成が含まれます。これらのスクリプトは、Reddit Web サイトをナビゲートし、Lalicat によって調整されたブラウザー プロファイルを利用して必要なデータを効率的に抽出するように明示的に設計されています。これらの要素をシームレスに調和させることで、検出されたり制限に遭遇したりすることなく、Reddit からデータを簡単に収集できます。

Webスクレイピングを行う際のヒント

Reddit で Web スクレイピング活動に参加する場合は、その活動が法的、持続可能、効率的な原則に確実に準拠するようにするためのいくつかの提案とガイドラインを以下に示します。

何よりもまず、サイトのポリシーに従うことが不可欠です。 Web サイトからデータを抽出する前に、そのサービス利用規約とプライバシー ポリシーをよく確認してください。特定の Web サイトでは、Web スクレイピングを明示的に禁止したり、データ抽出の事前承認を義務付けたりする場合があります。サイトポリシーに従わない場合、活動が停止されたり、法的影響を受ける可能性があります。

第二に、倫理的および法的基準を遵守します。 Web スクレイピングは、データがスクレイピングされる個人のプライバシーの保護やデータ保護法の遵守など、さまざまな倫理的および法的懸念を引き起こします。データが合法的かつ倫理的な目的でのみ取得されることを確認し、必要に応じて同意を取得するか、データを匿名化します。同時に、スクレイピングしたデータを悪用したり、違法または非倫理的な活動に使用したりしないでください。これらの予防措置により、Web スクレイピングの実践が倫理的および法的枠組みに沿ったものとなることが保証されます。

第三に、エラーと例外を適切に処理します。 Web スクレイピングでは、サーバー エラー、接続タイムアウト、無効なデータなどのエラーや例外が発生する傾向があります。失敗したリクエストを再試行したり、後の分析のためにエラーを記録したりするなど、適切な措置を実装して、これらの問題を適切に処理することが重要です。そうすることで、Web スクレイピング キャンペーンの効率と持続可能性が保証されます。

4 番目に、ユーザー エージェント文字列を利用します。ユーザー エージェント文字列は、Web クローラーに対して Web サイトを識別するコード スニペットです。 Web ブラウザで一般的に使用されるユーザー エージェント文字列を使用すると、検出を回避し、Web サイトによるスクレイピング活動の妨害を防ぐことができます。ただし、特定のサイトではユーザー エージェント文字列が検出される可能性があるため、注意して慎重に選択して使用するようにしてください。

5つ目は、代理人を雇うことです。プロキシは、IP アドレスをローテーションし、スクレイピング活動をブロックしようとする Web サイトによる検出を回避する目的を果たします。それにもかかわらず、禁止されたり法的影響に遭遇したりしないように、評判の良いプロキシプロバイダーを利用し、そのサービス利用規約に従うことが重要です。

最後に、サーバーに過度の負荷をかけないようにしてください。 Web スクレイピングは Web サイトのサーバーに大きな負荷をかける可能性があるため、過剰な量のデータをスクレイピングしたり、短期間に過剰な数のリクエストをサーバーに殺到させたりしないことが重要です。サイトの過負荷を防ぐために、リクエスト間の遅延を組み込んだり、オフピーク時間にデータを取得したりすることを検討してください。 Web スクレイピングは、インターネット データを収集および分析するための強力なツールです。ただし、法的範囲内で慎重に実行する必要があります。前述のヒントとベスト プラクティスに従うことで、Reddit での Web スクレイピング キャンペーンが持続可能かつ効率的で、法律に従って実施されるようになります。これにより、オンラインのプライバシーとセキュリティが保護されるだけでなく、データの収集と分析の有効性が向上し、ビジネスや研究の取り組みにおいてより正確で包括的な結果が得られるようになります。

結論

Web スクレイピング Reddit は、市場調査や競合他社の分析などのさまざまな目的に対して貴重な視点と知識を提供できる強力なメカニズムです。それにもかかわらず、Web スクレイピングに取り組むには、法的および倫理基準への準拠を確保し、Web サイトのブロックを回避するために、綿密な計画と適切なツールの利用が必要です。

Python は、Beautiful Soup、Scrapy、Selenium などの豊富なライブラリとツールにより、Web スクレイピング用のプログラミング言語として広く評価されています。これらのライブラリは、簡単な HTML 解析、Web ブラウジングの自動化、Web サイトからのデータ抽出を容易にします。

さらに、Lalicat は、複数のオンライン ペルソナと Web スクレイピングの取り組みを監視するように設計された、優れた Web スクレイピング管理ツールとして機能します。安全でプライベートなブラウジング環境を提供し、複数のブラウザ プロファイルの作成を可能にし、Web スクレイピング タスクを自動化し、プロキシ サーバーとの統合をサポートします。これらの属性により、複数のオンライン ID の管理と Web ベースのデータの取得を必要とする企業や個人にとって、これは不可欠な資産になります。

全体として、Web スクレイピングに Python と Lalicat を採用することで、組織や個人は効率を高め、倫理的および法的原則を遵守しながら、Web から貴重な洞察と情報を抽出する能力を強化できます。これらのツールを利用することで、Reddit のデータをシームレスにスクレイピング、分析し、その潜在力を活用して事業運営や研究活動に大きな価値をもたらすことができます。

したがって、私たちは、前述のヒントとベスト プラクティスを厳守するとともに、Web スクレイピング目的で Python と Lalicat を利用することを強く推奨します。ウェブ スクレイピングの世界をよりスムーズに開始できるように、提供されたリンクから Lalicat をダウンロードし、無料プランを利用して安全なウェブ スクレイピングの取り組みを開始できます。

無料トライアルを取得

すべての新規ユーザーに3日間の無料トライアルを提供

機能に制限なし